Quando um grande modelo de linguagem (LLM) com dados específicos é ajustado para ser usado para um propósito, o fenômeno de esquecimento da informação originalmente memorizada é chamado de “esquecimento catastrófico”.

Este é um problema bem conhecido e irritante no aprendizado de máquina, e surgiu uma técnica de ajuste fino que pode evitá-lo. A explicação é que, com isso, o modelo, conforme originalmente pretendido, pode ter a capacidade de raciocinar e responder questões de conhecimento geral, bem como de domínios específicos.

A Venture Beat informou no dia 12 (horário local) que a Tenyx, uma startup de inteligência artificial (IA) de voz, revelou um novo método de ajuste para resolver o esquecimento, um problema de aprendizagem profunda.

Em geral, quando um modelo previamente treinado é ajustado usando um conjunto de dados diferente, os pesos são ajustados de acordo com os novos dados, fazendo com que o modelo perca ou esqueça as informações obtidas através do treinamento atual. Isso naturalmente reduz o conhecimento e a capacidade de pensar sobre o LLM.

“Como resultado, um modelo ajustado pode responder melhor a entradas específicas, mas em vez disso pode ter um desempenho fraco quando se trata de conhecimentos gerais e tarefas de inferência, ou produzir repentinamente respostas potencialmente tendenciosas”, disse Itamar Ariel, CEO da Tenix. Fora.

Eles também explicaram que se um LLM for pré-treinado com um conjunto de frases em inglês e posteriormente usar um conjunto de dados de linguagem de marcação estrutural ou sintaticamente diferente, a maneira como o LLM captura informações, as transforma e gera novas informações pode mudar.

“Com estas mudanças, acabaremos por perder a nossa capacidade de produzir um inglês consistente”, disse Ariel.

Recentemente, a Técnica de Ajuste Fino de Eficiência de Parâmetros (PEFT) “LoRA” desenvolvida pela Microsoft (MS) é amplamente utilizada devido à sua baixa memória e requisitos computacionais. LoRa é uma forma de reduzir esses custos ajustando apenas alguns dos pesos em vez de todo o peso durante o ajuste fino. Ou seja, em vez de atualizar todos os parâmetros do modelo, apenas as alterações nos parâmetros do modelo são atualizadas.

Porém, Laura destacou que esta não é de forma alguma uma técnica para amenizar o esquecimento. A explicação é que se alguns pesos forem atualizados ajustando dados que não correspondem aos dados de treinamento originais, eventualmente será difícil identificar e corrigir a distorção.

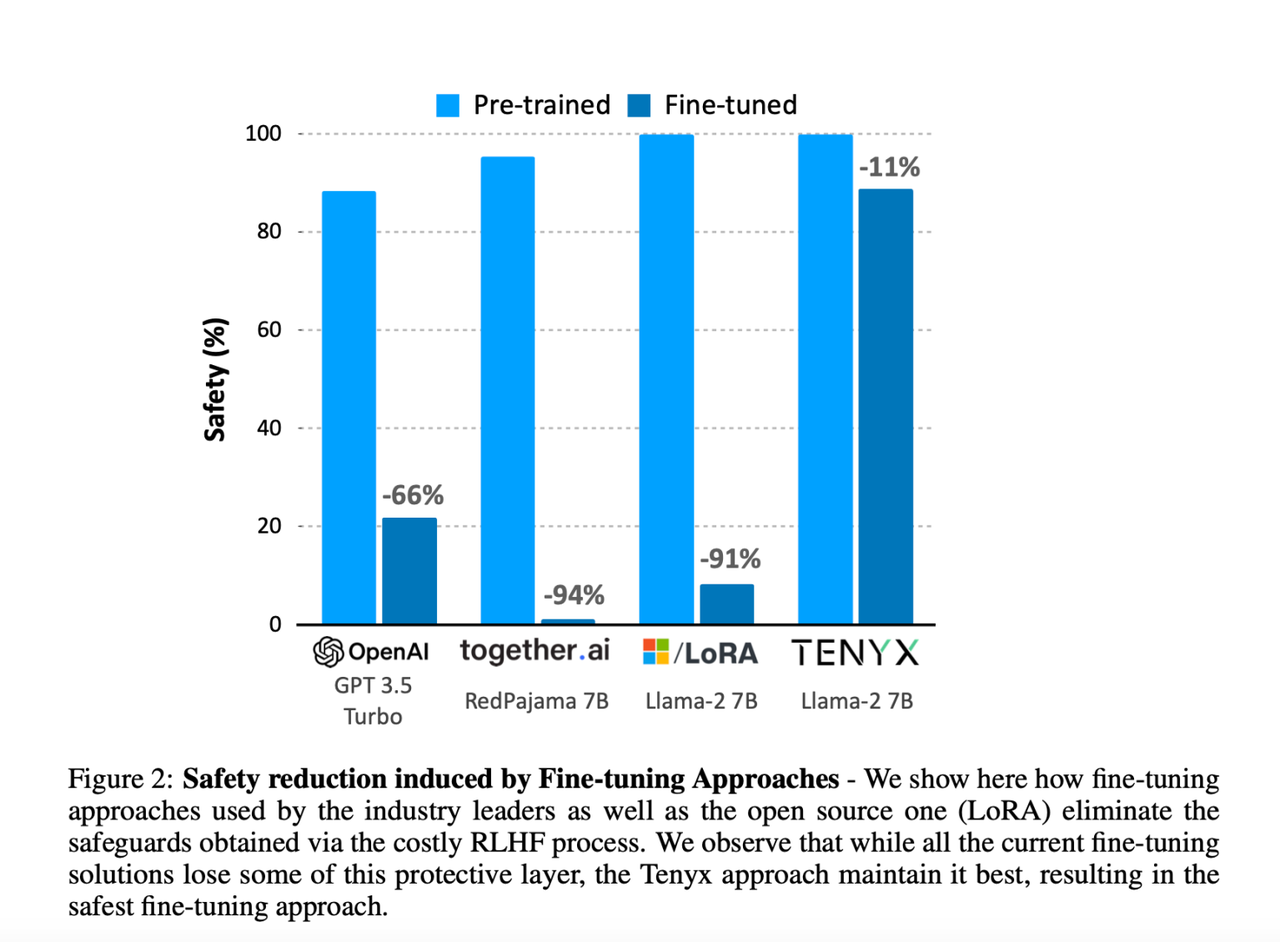

Além disso, o ajuste fino através do LoRa e de outros métodos existentes pode minar as medidas de segurança implementadas através do “Feedback Humano Reforçado de Aprendizagem” (RLHF), que é essencial para evitar resultados tendenciosos e prejudiciais do modelo. “Como o RLHF também é um procedimento de treinamento, ele é influenciado tanto quanto as habilidades cognitivas e de pensamento durante o ajuste fino.”

O método de ajuste fino da Tenics, por outro lado, define um subconjunto de parâmetros do modelo que podem ser atualizados e ajustados para novos dados, preservando quase todos os mapeamentos de entrada-saída com os quais o modelo foi originalmente treinado.

A plataforma então aplica atualizações de peso enquanto ajusta o espaço para não atrapalhar a maneira como captura informações dos dados pré-treinados.

“Para evitar ou reduzir o esquecimento, ajustando-nos a novos dados, analisamos mestres pré-treinados para determinar quais dos bilhões de pesos podem ser atualizados e como”, disse o CEO Ariel.

Isso nos permite escolher um subconjunto de pesos da rede e limitar as atualizações aos neurônios selecionados, retendo efetivamente todas as informações aprendidas anteriormente.

A Tenix comparou e avaliou tecnologias de ajuste fino de outras empresas. Como resultado, a estabilidade do Open AI diminuiu 66%, Together AI diminuiu 94%, Lora diminuiu 91%, enquanto a estabilidade do método Tenix diminuiu apenas 11%.

O mesmo aconteceu com o nível de habilidade. O “GPT-3.5 Turbo” da OpenAI, que possui muitos parâmetros, foi inicialmente superior, mas após o ajuste fino, o “Rama-2 7B” da Tenix foi o mais eficiente. Em particular, em termos de perda de conhecimento, a Tenix foi a que mais mitigou o problema do esquecimento, com uma perda de 3%, em comparação com 10% para Open AI, 40% para Together AI e 43% para Laura.

“O esquecimento é um problema bem conhecido na aprendizagem profunda e continua a afetar até modelos grandes e capazes, “disse Noah Goodman, professor associado da Universidade de Stanford. “Tenix tem uma forte equipe de pesquisa explorando novas ideias importantes para resolver este desafio. ” “Pronto”, ele disse.

Tenix lançou esta tecnologia como uma versão beta, Lista de espera no siteÉ a abertura.

Repórter Park Chan cpark@aitimes.com

“Pensador. Aspirante a amante do Twitter. Empreendedor. Fã de comida. Comunicador total. Especialista em café. Evangelista da web. Fanático por viagens. Jogador.”